Pianorolle, Sequenzer & MIDI

Steuerung von Musik- und Klangdaten

Pianorolle, Sequenzer oder MIDI-gesteuerte Instrumente – sie stehen alle mehr oder weniger in der Tradition von selbstspielenden Musikinstrumenten und Musikautomaten. Historisch betrachtet wurden bei mechanischen Musikinstrumenten meistens Tonfolgen automatisch durch einen je spezifischen Mechanismus gesteuert und wiedergegeben. Dass solche selbstspielenden Instrumente eine lange Geschichte haben, wird daran deutlich, dass es bereits im 3. Jh. v. Chr. derartige Instrumente gegeben haben soll. In den Schriften der Alexandrinischen Schule wird von künstlich singenden Vögeln, selbstspielenden Orgeln oder auch selbstspielenden Perkussionsinstrumenten berichtet. Im Folgenden sollen jedoch drei Arten der Steuerung von Musik- und Klangdaten vorgestellt werden, ohne die ein Arbeiten in und mit der DAW nicht denkbar ist.

Notenrollen & Pianorollen-Editor

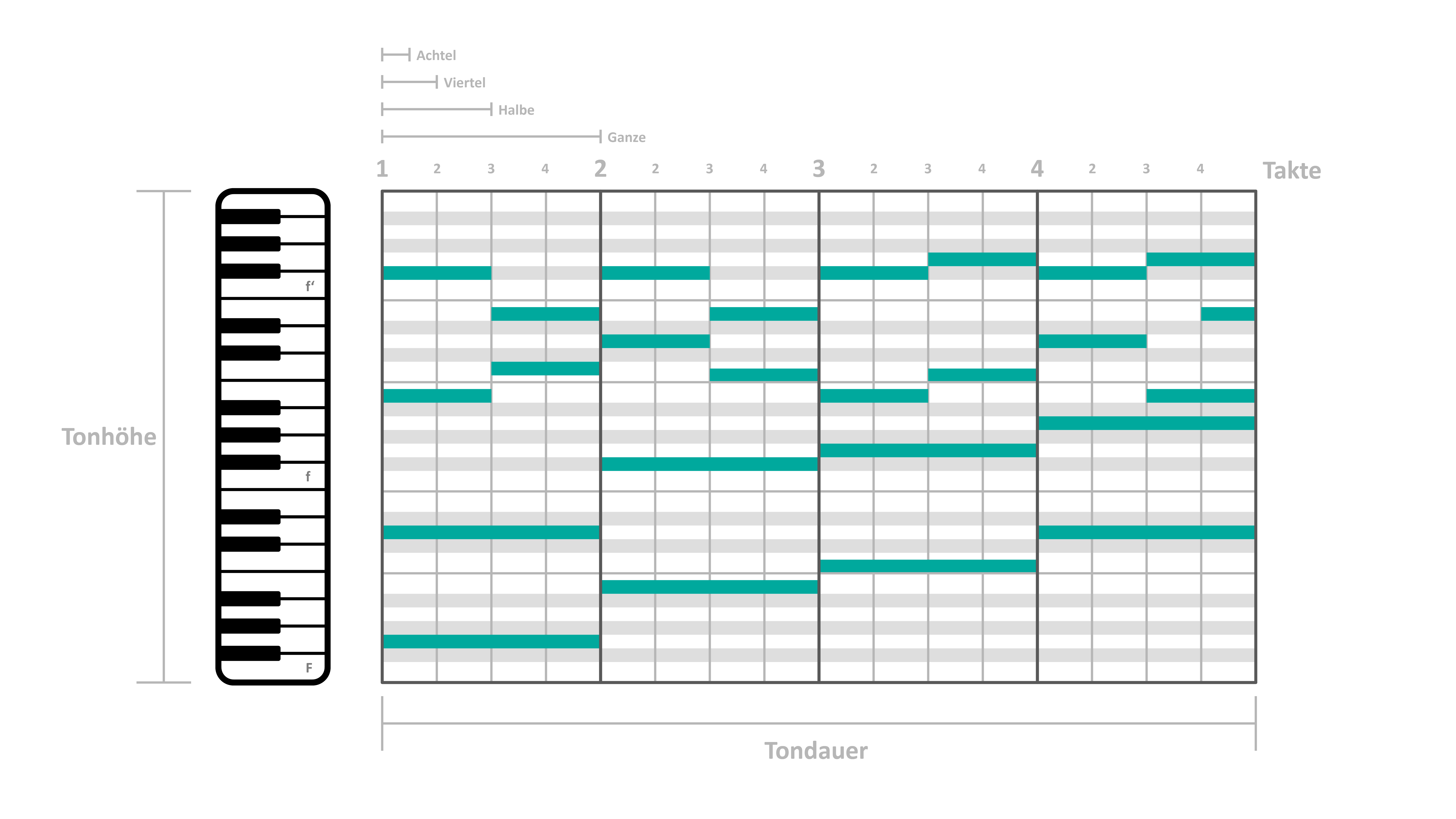

Der Pianorollen-Editor, kurz auch Pianoroll genannt, gehört zu einer der wichtigsten Arbeitsoberflächen in einer DAW. In der Pianorolle werden MIDI-Daten erzeugt und bearbeitet, womit sich sowohl Software- als auch Hardware-Instrumente steuern lassen. Jede DAW verfügt über eine Art der Pianorolle mit je eigenen Besonderheiten. Den meisten ist jedoch gemein, dass sich Pitch-, Velocity- und Längen-Werte der MIDI-Noten eintragen und bearbeiten lassen. Darüber hinaus sind aktuelle Pianorollen-Editoren zu einer vielseitigen Gestaltung von MIDI-Daten in der Lage. Die Editierfunktionen innerhalb der Pianorolle reichen von der üblichen Notensteuerung, über algorithmisch-randomisierte oder KI-informierte Sequenzen, der Steuerung von externen Instrumenten bis zur Steuerung sämtlicher Parameter von Software-Instrumenten.

Wie viele andere Funktionen der DAW, so ist auch der Pianorollen-Editor von einem historischen Vorläufer inspiriert. Bereits am Ende des 19. Jh. entwickelte die Aeolian Company aus New York ein marktfähiges, selbstspielendes Klavier, welches mithilfe von Notenrollen gesteuert wurde. Das Pianola wurde ab 1897 in den USA und ab 1902 in Deutschland auf den Markt gebracht. Selbstspielende Klaviere konnten sich weit verbreiten und galten um die Jahrhundertwende und die ersten Jahrzehnte des 20. Jh. als alternative Methode zur Aufnahme, Speicherung und Wiedergabe von Musik. Für die Steuerung der selbstspielenden Klaviere kam eine mehrere Meter lange Papierrolle, die Notenrolle zum Einsatz. Auf bzw. in dieser Notenrolle sind die Noteninformation primär durch eine Lochung eingetragen. Je nach Rollentyp lassen sich hier neben Tonhöhe und -dauer auch Akzente und Pedaleinsätze steuern. Um die gelochten Noten- und Spielinformationen abrufen zu können, läuft die Notenrolle über eine Vorrichtung innerhalb des Instrumentes, den sogenannten Notengleitblock, mit dem die Lochungen pneumatisch abgetastet werden können. Sobald eine Lochung den Notengleitblock passiert, schließt sich ein kleiner Balg, wodurch bspw. der Tastendruck ausgelöst wird.

Mit der Zeit etablierten sich zwei unterschiedliche Formen selbstspielender Klaviere: das Kunstspiel- und das Reproduktionsklavier. Kunstspielklaviere benötigen eine aktive menschliche Beteiligung zur Wiedergabe der Notenrollen. Über Handhebel und/oder Pedale können die Spielenden das Tempo, die Dynamik, Dämpfungen und klangliche Eigenheiten steuern. Es kommt also zu einer Interpretation der Notenrolle. Demgegenüber dienten Reproduktionsklaviere, wie der Name bereits verrät, ausschließlich der Reproduktion der Notenrolle, also einer automatischen Wiedergabe der gespeicherten Musik. Ein manueller Eingriff ist hierfür nicht notwendig.

Analoge und digitale Sequenzer

Im Bereich der Instrumententechnik bezeichnen Sequenzer Steuereinheiten von i.d.R. elektronischen Instrumenten wie Synthesizer, Sampler oder Drum Machines. Sequenzer können analog oder digital arbeiten und dienen der schrittweisen Kontrolle unterschiedlicher musikalischer und/oder klanglicher Parameter (u.a. Tonhöhe, Filtereinstellung oder Wellenform). Die ersten Sequenzer in dieser Form wurden im Laufe der 1950er-Jahre entwickelt. Beinah zeitgleich lassen sich vergleichbare Steuereinheiten in unterschiedlichen Instrumenten finden. So sind unter anderem lochstreifengesteuerte Sequenzer im RCA Synthesizer I von 1951 verbaut. Die RCA (Radio Corporation of America), damals eines der größten Medien- und Unterhaltungsunternehmen der USA, beauftragte die Ingenieure Harry Olson und Hebart Belar damit, ein Instrument zu entwickeln, das in der Lage war Pop-Hits zu generieren. Die Hoffnung der RCA war, dass sich mithilfe eines Hit-Automaten die Kosten bei der Musikproduktion, verursacht u.a. durch Orchester, Studio und Personal, minimieren lassen würden. Nicht nur wurden dafür Tausende Songs analysiert, auch entstand aus diesem Projekt heraus einer der ersten programmierbaren Synthesizer. Der RCA Synthesizer Mark I war eine raumeinnehmende Maschine, die im Computer Music Center der Columbia University ihren Platz hatte. Auch wenn sich einiges über den Musikautomaten und Synthesizer der RCA sagen ließe, so soll hier auf die Sequenzer-Einheit verwiesen werden. Hierfür wurde die Partitur in Papierrollen gestanzt und für jede einzelne Note der Pitch, die Klangfarbe, Lautstärke und auch die Hüllkurve, also der Amplitudenverlauf definiert.

In Kanada beschäftigte sich Hugh Le Caine mit einer ganz ähnlichen Methode, musikalische Abläufe technisch zu steuern. Le Caine ist bekannt für sein monophones, anschlagdynamisches Keyboard-Instrument namens Sackbut, das er zwischen 1945 und 1948 entwickelte. Dieses Instrument, das nach der Barockposaune benannt ist, nimmt einige Features vorweg, die wir mit heutigen Synthesizern und Keyboard-Instrumenten in Verbindung bringen: eine anschlagdynamische Klaviatur, stufenlose Übergänge zwischen den Wellenformen sowie Frequenzmodulation. Le Caine gilt auch als Ideengeber für das Modulationsrad bzw. Modulation Wheel und den Joystick zur Modulation von klanglichen Parametern, die so auch heute noch bei fast allen Synthesizern verbaut sind. So konnte die linke Hand beim Spielen des Sackbut bspw. die Wellenformen, die Formanten und weitere Parameter kontrollieren. In den frühen 1950er-Jahren arbeitete Le Caine an einer Art Sequenzer, der von den Papierwalzen zur Steuerung von selbstspielenden Klavieren oder Musikautomaten inspiriert war. So entwarf Hugh Le Caine den „Coded Music Apparatus“, der graphische Aufzeichnungen von Musik in Klang umsetzen konnte. Die Idee der Apparatur ist folgende: Für die Komposition werden fünf Kurven auf eine Papierrolle gezeichnet, die den musikalischen und klanglichen Vorstellungen entsprechen. Jede aufgezeichnete Kurve repräsentiert den zeitlichen Verlauf zur Steuerung musikalisch-klanglicher Parameter: Tonhöhe, Amplitude und drei klangfarbliche Parameter wie z. B. die Wellenform. Beim Abspielen des Gerätes bewegte sich die Papierrolle nun durch den Apparat, wobei jede Kurve abgetastet wurde, wodurch die unterschiedlichen Potentiometer mithilfe einer Steuerspannung dirigiert wurden. Der Sequenzer von Le Maines steuerte einen modifizierten Sackbut, wodurch sich ein vollwertiger elektromechanischer Musikautomat ergab, der Steuereinheit mit Syntheseeinheit verband.

Heutige Sequenzer sind selbstverständlich flexibler, kleiner und mit verschiedenen Instrumenten kompatibel. Die Grundidee bleibt jedoch bestehen. Analoge Sequenzer geben meist schrittweise Steuerspannungen und Trigger-Signale aus, die zur Kontrolle spannungsgesteuerter Synthesizer genutzt werden können. 8-Step- und 16-Step-Sequenzer haben sich hierbei als Standard durchgesetzt, wobei auch andere Schrittzahlen zu finden sind. Jeder dieser Schritte wird i. d. R. durch ein Potentiometer spannungsgesteuert, wodurch die Sequenz „programmierbar“ wird. Auch wenn Sequenzer meist in Schleife, also im Loop laufen, so kann der Sequenzer auch zum einmaligen Durchlauf genutzt werden. Mithilfe des Sequenzers können u.a. Pitch-Einstellungen programmiert werden, sodass Melodien entstehen, Filtereinstellungen moduliert werden, die für dynamische Sequenzen sorgen können oder auch Klangfarbenmodulationen vorgenommen werden. Die Möglichkeiten sind vielfältig, besonders, wenn sich, wie bei komplexeren Sequenzern, mehrere unterschiedlich laufende Sequenzen überlagern.

Digitale Sequenzer funktionieren von Prinzip her gleich. Sie werden ebenfalls zur Steuerung von musikalisch-klanglicher Parameter von elektronischen Instrumenten eingesetzt. Hier kommen jedoch keine Steuerspannungen, sondern digitale Steuersignale zum Einsatz. Dienten die ersten digitalen Sequenzer der Steuerung von analogen Synthesizern, so etablierten sich digitale Sequenzer mit der Einführung des MIDI-Protokoll im Jahr 1982 als Standard. MIDI, mittlerweile ein Kommunikationsprotokoll zwischen Instrumenten, Computern, Video-Software oder auch Effektgeräten, löste die Steuerspannung zur Parameterkontrolle durch Sequenzer ab. In digitalen Sequenzern steuern statt CV- und Trigger-Signale digitale Signalfolgen, die durch den MIDI-Industriestandard genormt sind, die unterschiedlichen Parameter zur Modulation und Synthese von Musik und Klang. Das MIDI-Protokoll ist in der Lage, mehrere Parameter gleichzeitig über ein Kabel zu steuern, was das Arbeiten mit und Kommunizieren zwischen digitalen Sequenzern und elektronischen Instrumenten zwar erleichtert, die Programmierarbeit jedoch erhöht. Auch der Pianorollen-Editor innerhalb einer DAW (s.o.) erfüllt die Funktionen eines Sequenzers, womit jede DAW wesentliche Sequenzerfunktionen bei der Musik- und Klangproduktion übernehmen kann.

Euklidische Sequenzer

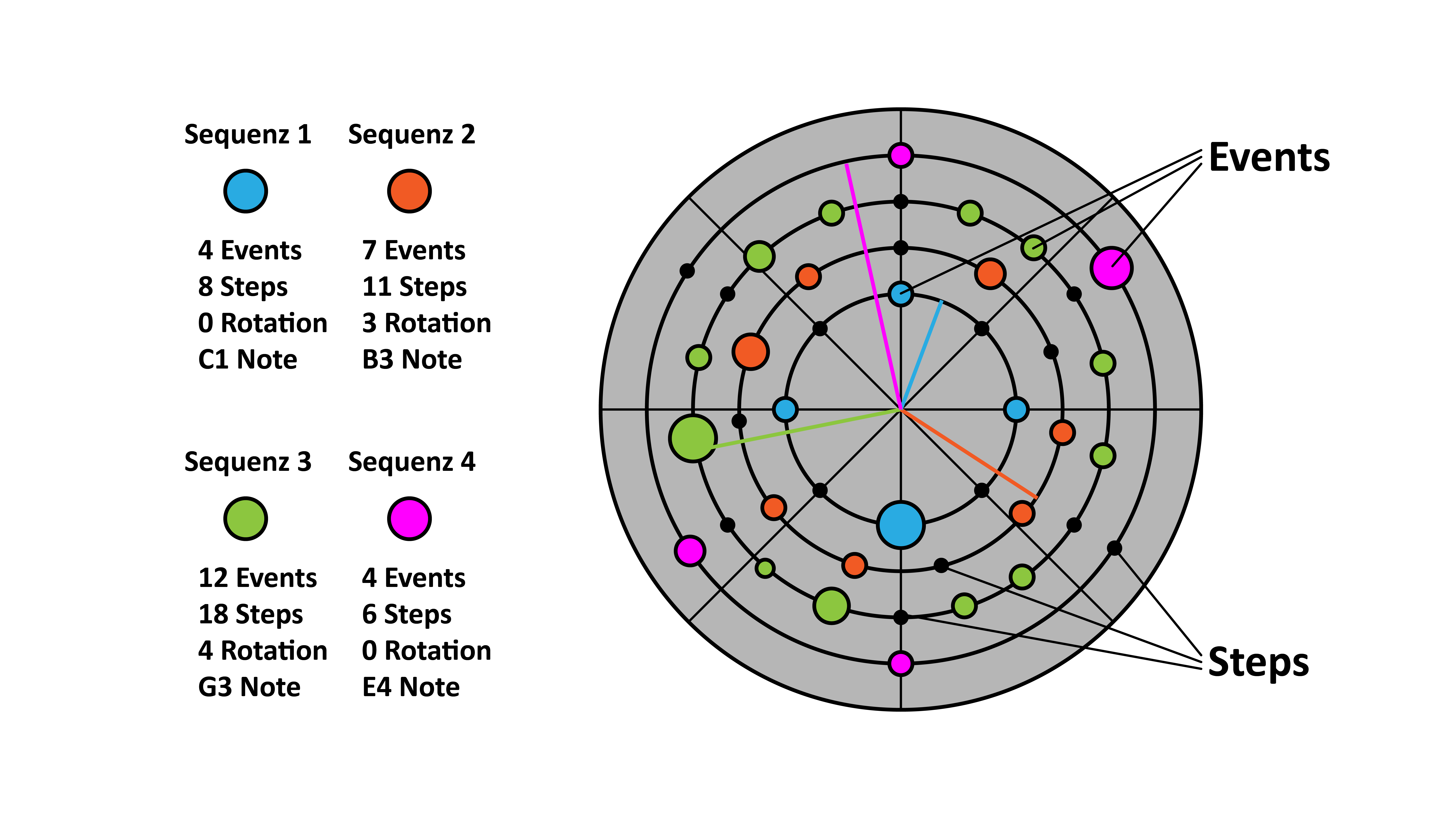

Mit der Zeit haben sich unterschiedliche Arten von Sequenzern herausgebildet. Auf dem Markt lassen sich algorithmische, Performance-orientierte Sequenzer zur Steuerung der DAW oder von Synthesizern, zahlreiche klassische Step-Sequenzer oder auch komplett frei konfigurierbare Sequenzer ohne Metrum finden. Eine Art soll hier in Kürze vorgestellt werden: Euklidische Sequenzer. Im Kern geht es bei euklidischen Sequenzern darum, dass die Verteilung einzelner Ereignisse (wie Noten, Impulse, Parametereinstellungen) in bspw. einem Takt immer gleichbleibt, unabhängig davon um wie viele Ereignisse und Schritte es sich handelt.

Gehen wir vom einfachen Fall aus, dass vier Ereignisse auf 16 Schritte gleichmäßig verteilt werden sollen, dann ergibt sich eine Sequenz, in der musikalisch gesprochen auf jeder Viertelnote ein Ereignis stattfindet. In der Popmusik würde man dieses Pattern four-on-the-floor oder 4-to-the-floor nennen. Alternativ kann man sich auch eine Sequenz vorstellen, bei der drei Ereignisse auf zwölf Schritte verteilt werden sollen. Das Resultat wäre eine triolische Sequenz. Euklidische Sequenzer gehen aber über solche musikalisch etablierten Taktstrukturen hinaus. Denn problemlos lassen sich auch sieben Ereignisse auf 23 Schritte oder fünf Ereignisse auf 17 Schritte in einem Takt gleichmäßig verteilen, womit die taktbezogenen Zählzeiten komplett aufgebrochen werden. In vielen Fällen lässt sich zudem die Position der Ereignisse rotieren, damit nicht jedes erste Ereignis auf der schweren Zählzeit eins stattfindet. Die meisten euklidischen Sequenzer können zudem mehr als eine Sequenz ausgeben, wodurch sich rhythmisch hoch komplexe Taktstrukturen ergeben können. Der euklidische Sequenzer steuert neben den rhythmischen Einheiten auch Parameter wie Tonhöhe oder auch die Richtung der Sequenz bzw. der Sequenzen, womit sich auch komplexe Melodien und Harmonien ergeben können, die erst nach einer hohen Anzahl an Durchläufen zu Wiederholungen führen. Die meisten euklidischen Sequenzer setzen auf eine graphische Darstellung in Kreisform, da sich die Verteilung der einzelnen Ereignisse hier am ehesten nachvollziehen lassen.

MIDI

MIDI ist ein Akronym für „Musical Instrument Digital Interface“. Dieser Industriestandard ermöglicht eine Software- und Hardware-Verknüpfung sowie den Datenaustausch zwischen elektronischen Instrumenten. Die Einführung von MIDI hat sich derart tiefgreifend auf den Instrumentenmarkt ausgewirkt, dass eine nicht vorhandene MIDI-Schnittstelle bei elektronischen Instrumenten, in Audio-Interfaces oder in modernen Effektgeräten die absolute Ausnahme bildet. Sogar modulare Synthesizer-Systeme, die sich von Klaviatur- und MIDI-Steuerung distanzieren möchten, verfügen über eigenständige Utility-Module mit MIDI-Schnittstellen.

MIDI wurde im August 1983 auf der jährlichen Messe der „National Association of Music Merchants“, kurz NAMM, vorgestellt, nachdem über ca. anderthalb Jahre hinweg zwischen den führenden Herstellern elektronischer Instrumente Gespräche und Diskussionen über einen solchen Standard geführt wurden. Durchsetzen konnte sich letztlich eine transpazifische Zusammenarbeit zwischen Dave Smith, dem damaligen Präsidenten von Sequential Audio und Ikutaro Kakehashi, Gründer und Präsident von Roland. So kommt es, dass noch vor der Präsentation von MIDI auf der NAMM 1983 die ersten elektronischen Instrumente mit MIDI-Schnittstelle auf dem Markt erschienen: der Prophet 600 von Sequential Circuits (Dez. 1982), der Roland Jupiter 6 (Jan. 1983) und der legendäre Yamaha DX7 (Jun. 1983). Im selben Jahr hatte man sich auch die Art der Steckverbindung geeinigt. Der fünfpolige Diodenstecker und später der fünfpolige DIN-Stecker sollten von nun an die Kommunikation zwischen elektronischen Instrumenten und später auch zwischen Soft- und Hardware übernehmen. MIDI-Daten werden seriell und ohne Datenflusskontrolle übertragen. Da die Vielzahl an musikalischen Daten in Echtzeit übertragen werden muss, wurde eine möglichst hohe Übertragungsrate von 31.250 Bits pro Sekunde gewählt. Übertragen werden die Daten über ein fünfpoliges Kabel mit dem bereits erwähnten DIN-Stecker. Das Stecksystem ist simpel und dennoch vielseitig. Über die MIDI-In-Buchse werden Daten empfangen, über die MIDI-Out-Buchse werden Daten gesendet und die MIDI-Thru-Buchse dient der Weiterleitung von Daten. Sobald ein Gerät bspw. ein analoger Synthesizer über die MIDI-Out-Buchse mit der MIDI-In-Buchse eines anderen bspw. eines digitalen FM-Synthesizers verbunden ist, so lassen sich, sofern beide auf demselben MIDI-Kanal kommunizieren, über die Tastatur des analogen Synthesizers beide Instrumente zeitgleich bedienen. Weitere Schaltungsmöglichkeiten sind in den Abbildungen dargestellt.

Das Senden von MIDI-Daten erfolgt über 16 zuweisbare MIDI-Kanäle (MIDI-Channels od. Channels). Das Verpacken und Versenden der Daten über einzelne Kanäle ermöglicht es, zeitgleich Daten an diverse Instrumente und unterschiedliche Befehle zu verteilen. Musikalisch gesprochen lassen sich so bspw. Basslinien an ein Gerät, Akkorde an ein weiteres Gerät, die Melodielinie an ein drittes und letztlich auch Drum-Sequenzen an einen Sampler oder eine Drum-Machine versenden, ohne dass sich diese Daten in die Quere kommen könnten. Die serielle Datenübertragung verläuft wie folgt: 10 Bits bilden die kleinste übertragbare Dateneinheit, ein MIDI-Daten-Byte. Die eigentliche Information, Bits 0-7, werden von einem Start- und einem Stopp-Bit umrahmt. Ein weiteres Bit definiert, ob es sich um Status- oder ein Daten-Byte handelt. Dies sind die zwei grundlegenden Arten der Information, in die MIDI-Signale unterteilt werden. Ein Beispiel: Soll einem Instrument übermittelt werden, dass und welche Taste gedrückt wird, so sind drei MIDI-Bytes notwendig. Zu Beginn steht das Status-Byte. Hierin enthalten sind Informationen über das nun folgende Ereignis, sprich es folgen Tastaturdaten auf bspw. MIDI-Kanal 1. Es folgen nun zwei Daten-Bytes. Definiert das erste die Tonhöhe (jedem Ton wird eine MIDI-Nummer zugewiesen, s. Abb.), so wird im zweiten Daten-Byte die Anschlagsstärke übermittelt. Dies ist die Mindestmenge an Daten, die benötigt wird, um das Drücken einer Taste in MIDI-Daten zu übermitteln. Aufgrund der Festlegung auf den MIDI-Standard müssen sich Anwender*innen elektronischer Instrumente keine Gedanken über den Datenaustausch zwischen ihren Instrumenten machen. Lediglich die MIDI-Kanäle müssen richtig zugewiesen werden und bei komplexeren Setups können zudem noch Controller programmiert werden, die dann über sogenannte Program-Change-Befehle (MIDI PC) zwischen Presets hin- und herschalten oder über sogenannte Control-Change-Befehle (MIDI CC) weitere Parameter wie die Filtereinstellungen steuern können. Viele der über MIDI steuerbaren Parameter werden in einer Auflösung von 0-127 angegeben. So wird die Tonhöhe über in Zahlen von 0-127 codiert, die je einem Halbton entsprechen. Das ergibt den massiven Tonumfang von zehneinhalb Oktaven. Auch die Dynamik, die sogenannte Velocity kennt 128 Werte, bei denen 0 keinen Ton überträgt und 1 den leisesten und 127 den lautesten Wert repräsentiert.

Aftertouch & MIDI Polyphonic Expression (MPE)

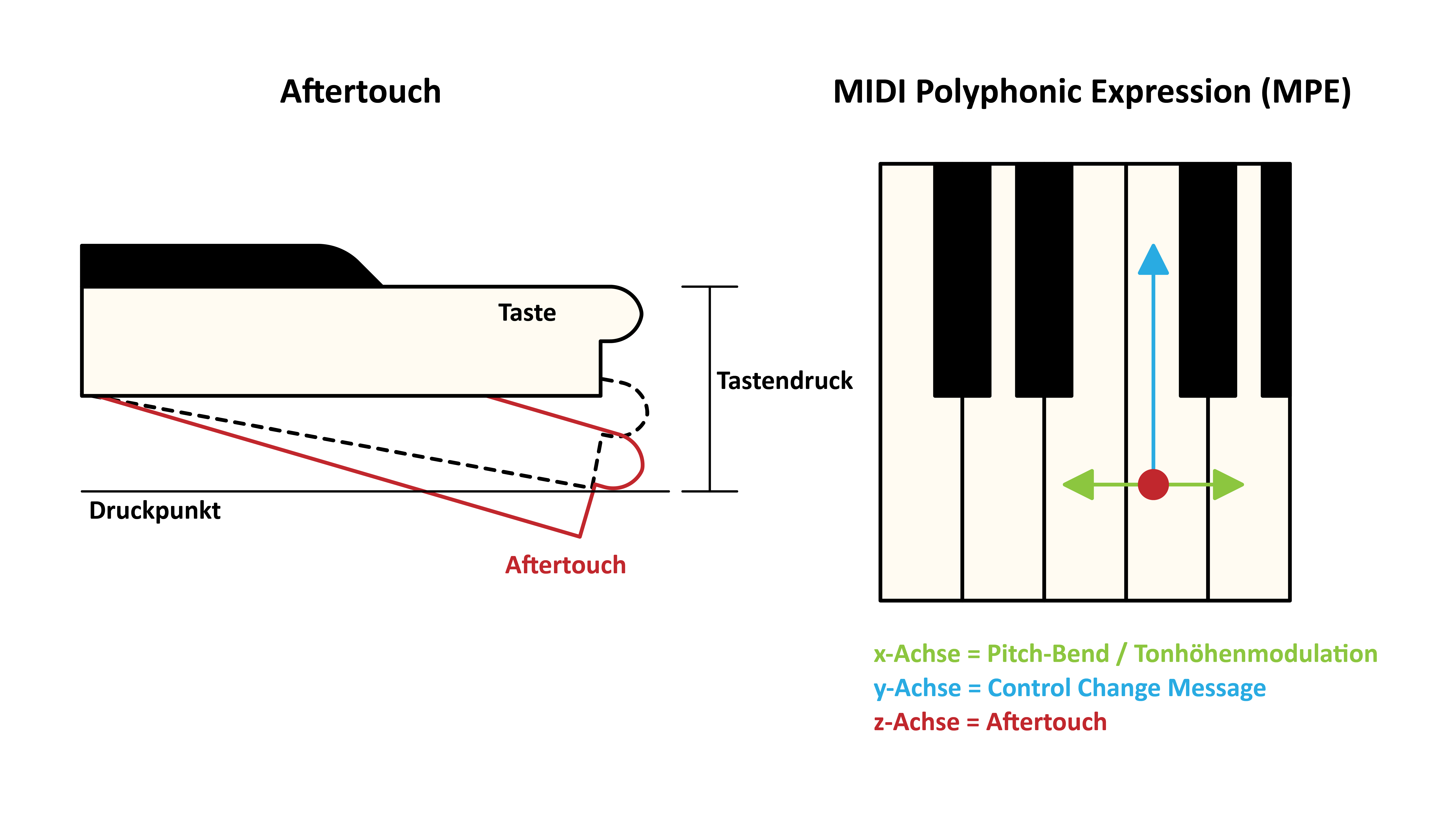

Der MIDI-Standard ermöglicht nicht nur die Steuerung und Programmierung von mehreren elektronischen Instrumenten gleichzeitig, er sorgt auch für neue Spieltechniken, kompositorische und musikalische Praktiken. Auf spieltechnische und Tastatur-bezogene Besonderheiten soll im Folgenden in aller Kürze eingegangen werden: Aftertouch und MIDI Polyphonic Expression (MPE). Aftertouch ist ein Tastenbefehl, der das Herunterdrücken der Taste nach dem normalen Tastenanschlag als gesondertes MIDI-Steuersignal erkennt. Auch wenn nicht alle MIDI-fähigen Instrumente und Synthesizer über diese Funktion verfügen, da hierfür eine spezielle Keyboard-Tastatur benötigt wird, ist Aftertouch dennoch verbreitet. Mit der Aftertouch-Funktion lassen sich weitere Parameter wie bspw. das Oszillator-Fine-Tuning oder Filtereffekte steuern und fördern so ein expressives Spiel. Der Vorteil, der sich bietet, ist, dass der bereits erklingende und gespielte Ton oder Klang über das stärkere und erneute Drücken der Taste während des Spiels klanglich variiert werden kann. Es gibt zwei Formen, monophoner und polyphoner Aftertouch. Polyphoner Aftertouch ermöglicht eine Steuerung der zu modulierenden Parameter für jede Taste einzeln, beim monophonen Aftertouch wirkt sich der zusätzliche Tastendruck global auf alle Töne aus. Konkret heißt das, dass bei polyphonem Aftertouch und einem gehaltenen C-Dur Akkord, das Nachdrücken auf nur einer Taste, der Note g bspw. auch nur für das g eine Modulation erfolgt (sei es eine Filtereffekt, Tonhöhenmodulation, Wellenformmodulation, o. Ä.). Der konstruktive Aufwand und die zu übertragene Datenmenge ist bei einem polyphonen Aftertouch-System um ein Vielfaches höher als bei dem herkömmlichen, monophonen Aftertouch. Entsprechend sind elektronische Instrumente mit polyphonem Aftertouch seltener und kostspielig.

Auch wenn der MIDI-Standard seit den frühen 1980er-Jahren besteht, erfolgen regelmäßig Neuerungen und Erweiterungen. So wurde 2018 MIDI Polyphonic Expression (MPE) als Standard zum bestehenden MIDI-Standard hinzugefügt. Auch hierbei handelt es sich, den Aftertouch-Funktionen ähnlich, um eine Steuerfunktion, die auf eine ausdrucksstarke und expressive Spielbarkeit des Instruments ausgelegt ist. MPE ermöglicht das gleichzeitige Steuern von mehreren Parametern pro Tastendruck (wie beim polyphonen Aftertouch) über speziell dafür angefertigte Keyboard-Tastaturen. Denn die Besonderheit ist nun, dass nicht nur das erneute Herunterdrücken, sondern auch horizontale und vertikale Fingerbewegungen auf der Taste als Steuersignale erkannt werden. MPE wurde dem Branchenverband MIDI Manufacturer’s Association im Jahr 2015 unter anderem von Roger Linn, dem Entwickler des ersten programmierbaren Sample-basierten Drum-Computers, der Linn LM-1 von 1979, und weiteren progressiven Entwickler*innen von Haken Audio und Roli, die Wegbereiter im Bereich mehrdimensionaler Klaviaturen und Tastaturen sind, vorgeschlagen. Seit 2018 gilt MPE als Teil des MIDI-Standards und findet sich mehr und mehr in Software- und Hardware-Instrumenten. So verfügt auch die DAW Ableton Live über MPE-fähige Software-Synthesizer, die mit ihrem MPE-fähigen Controller Push 3 auch steuerbar sind. Auch verfügen neuere analoge, polyphone Synthesizer wie der Polybrute 12 der französischen Firma Arturia oder der Osmose von der ebenfalls französischen Firma Expressive E über MPE-taugliche Tastaturen, die ein sehr vielseitiges und ausdrucksstarkes Spiel erlauben.

- Diduck, Ryan Alexander, Mad Skills. MIDI and Music Technology in the 20th Century, London: Repeater 2018

- Köpp, Kai, „Das Reproduktionsklavier: Zwischen Musikinstrument und Medium“ In Marion Saxer (Hrsg.), Spiel (mit) der Maschine. Musikalische Medienpraxis in der Frühzeit von Phonographie, Selbstspielklavier, Film und Radio, Bielefeld: transcript Verlag, 2016, S. 157-176.

- Müller, Meinhard, Information Retrieval for Music and Motion, Berlin: Springer 2007.

- Ruschkowski, André. Elektronische Klänge und musikalische Entdeckungen. Ditzingen: Reclam 1998, S.87-108, S.175-181, S.384-425.

- Wolf, Rebecca, „Spielen und bedienen. Das selbstspielende Klavier als virtuose Maschine“ In Marion Saxer (Hrsg.), Spiel (mit) der Maschine. Musikalische Medienpraxis in der Frühzeit von Phonographie, Selbstspielklavier, Film und Radio, Bielefeld: transcript Verlag, 2016, S. 137-156.

Piano Rolls & Sequenzen Playlist

- “Novelette in Fourths” – George Gershwin (aufgenommen zwischen1916 und 1927, Nonesuch 1993)

- “Study No. 3a (1948/1949)” – Conlon Nancarrow (Other Minds 2008)

- “Chase” – Giorgio Moroder (The Island Def Jam 1978)

- “Cinnamon Road” – Tangerine Dream (Virgin 1983)

- “Voodoo Ray” – A Guy Called Gerald (Rham Records 1988)

- “Stranger Things” – Kyle Dixon & Michael Stein (Lakeshore 2016)

- “Poly” – Daphni (Jiaolong 2017)

- “Vulture” – Daphni (Jiaolong 2017)